Hoje, as redes de banda larga não têm uma maneira de filtrar o tráfego com base na latência. E isso cria uma desvantagem significativa para aplicativos sensíveis ao tempo, como jogos online e day trading, que estão crescendo em popularidade. Felizmente, isso está prestes a mudar. O DOCSIS de baixa latência (LLD), conforme proposto por CableLabs, especifica uma separação lógica entre o tráfego regular e o tráfego sensível à latência. Ao criar duas filas de tráfego separadas, os MSOs têm a oportunidade não apenas de melhorar a experiência do usuário, mas também de oferecer um novo nível de serviço para gerar receita adicional.

A importância da baixa latência

No que diz respeito ao desempenho da rede, velocidade e latência são métricas muito diferentes. Embora estejam relacionados - e muitas vezes confundidos - eles têm requisitos únicos. As altas velocidades permitem a transferência de grandes quantidades de dados. Um bom exemplo é o streaming de vídeo em 4K do YouTube ou o download de um patch de software de 25 GB para um jogo. Para que isso aconteça rapidamente, velocidades altas de largura de banda são imperativas. No entanto, há momentos em que a velocidade por si só não é suficiente para oferecer a melhor experiência de qualidade. Um exemplo claro disso é o popular jogo multiplayer online Call of Duty. A renderização em tempo real do ambiente de jogo dinâmico é extremamente exigente, com pacotes de dados típicos transmitidos a uma taxa de bits de 100 kbps a 200 kbps tanto no upstream quanto no downstream. Mas isso é apenas metade da história.

Como Call of Duty é online, interativo e envolve vários jogadores competindo e colaborando em um servidor comum, a latência tem um impacto indiscutivelmente maior na jogabilidade do que a velocidade. Neste ambiente acelerado, atrasos de conexão de milissegundos são a diferença entre o sucesso e a falha. Como tal, a baixa latência é uma vantagem bem reconhecida em jogos multijogador online. Com latência mais baixa - isto é, o tempo que os pacotes passam alcançando o servidor de jogos Call of Duty e retornando uma resposta ao jogador multijogador - os jogadores podem literalmente ver e fazer coisas no jogo antes que outros possam. Mais importante, é uma vantagem pela qual muitos jogadores estão dispostos a pagar. Se aplicarmos essa mesma lógica e vantagem competitiva para finanças e day trading, é óbvio por que profissionais e amadores estariam dispostos a pagar por isso também.

O que causa a latência?

Para minimizar a latência, é útil entender suas condições subjacentes. Primeiro, existem várias fontes de latência em redes DOCSIS, incluindo atrasos de enfileiramento dependentes de protocolo e aplicativo, atraso de propagação, atraso de solicitação-concessão, configuração de canal, bem como atrasos de comutação e encaminhamento.

Normalmente, todo o tráfego de rede se funde em um único fluxo de serviço DOCSIS. Esse tráfego inclui fluxos que criam filas - como aplicativos de streaming de vídeo - e fluxos que não criam filas - como aplicativos de jogos multijogador. O desafio que esta arquitetura de fluxo única apresenta é a falta de distinção entre os dois tipos de tráfego. Tanto o aplicativo de jogo quanto o aplicativo de streaming de vídeo são tratados da mesma forma na rede, mas suas necessidades são muito diferentes: um congestionamento pode não ser importante para o propósito de assistir a um vídeo do YouTube, que pode ser reproduzido de forma assíncrona e em buffer, mas para competir em um jogo multiplayer de Call of Duty, ficar preso na fila de streaming de vídeo é uma sentença de morte. O tratamento indiscriminado do tráfego nas redes DOCSIS de hoje adiciona latência e jitter precisamente onde é indesejado.

A vantagem do DOCSIS de baixa latência

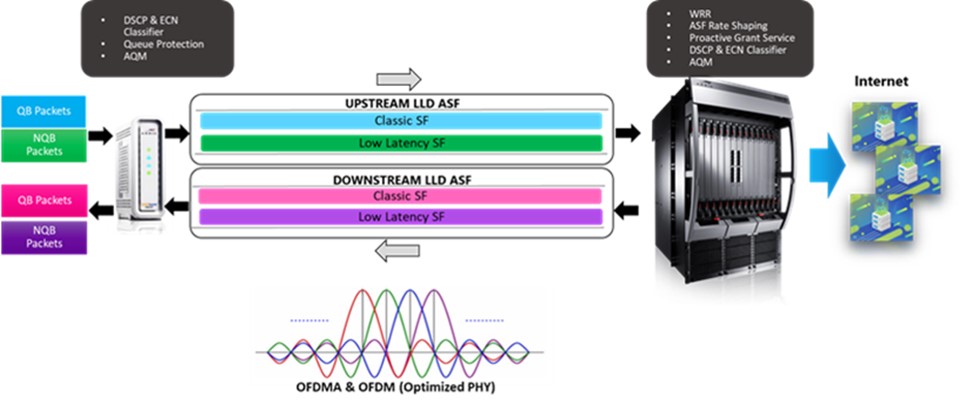

A arquitetura LLD usa uma construção chamada Aggregate Service Flow (ASF) para atribuir seus dois fluxos de serviço subjacentes ao tráfego de criação de fila (conhecido como "fluxo de serviço clássico") e ao tráfego de não criação de fila (conhecido como "fluxo de serviço de baixa latência”). Este arranjo resolve com precisão o problema de enfileiramento identificado acima e garante que os dados do aplicativo de criação de fila na rede de acesso DOCSIS não causem atrasos para dados de não criação de fila sensíveis ao tempo. Em outras palavras, os vídeos dos clientes não atrapalham seus jogos.

Especificamente, a arquitetura LLD oferece vários novos recursos principais:

Encapsulamento de fluxo de serviço ASF – O LLD ASF gerencia a modelagem de tráfego de ambos os fluxos de serviço, impondo uma Taxa Máxima Sustentada Agregada (AMSR), na qual a AMSR é o total combinado das taxas de bits de fluxo de serviço clássico e de baixa latência.

Weighted Round Robin Scheduler – O mecanismo de concessão no LLD é governado por um planejador de fluxo entre serviços Weighted Round Robin em execução no CMTS, que prioriza condicionalmente o fluxo de baixa latência para várias configurações configuráveis.

Tipo de agendamento de Serviço de Concessão Proativa – LLD apresenta um novo tipo de agendamento de dados revolucionário conhecido como Serviço de concessão proativa, que permite um ciclo de concessão de solicitação mais rápido, eliminando a necessidade de uma solicitação de largura de banda.

Classificação de tráfego de fluxo de serviço – Esta classificação de pacote desempenha um papel crucial na colocação de um determinado pacote no fluxo de serviço clássico ou de baixa latência.

Algoritmos de gerenciamento ativo de filas – O novo fluxo de serviço clássico usa o algoritmo DOCSIS PIE existente e descarta pacotes à medida que as filas são criadas para manter uma latência de destino. Enquanto isso, o fluxo de serviço de baixa latência implementa um novo algoritmo AQM conhecido como AQM Imediato, que não descarta pacotes, mas marca o campo ECN no cabeçalho IP com bits Congestion Experienced (CE) para garantir uma fila rasa. Os dois algoritmos AQM têm probabilidades acopladas para garantir que a capacidade de largura de banda seja compartilhada por ambos os fluxos de serviço.

Proteção de fila – Esse recurso categoriza os pacotes nos fluxos de dados do aplicativo chamados Microfluxos e garante que cada microfluxo seja direcionado ao fluxo de serviço apropriado, dependendo do tipo de tráfego de rede (QB ou NQB) e do limite crítico de latência.

Histogramas de latência – Um novo recurso de histograma oferecerá maior visibilidade dos buffers de fluxo de serviço e acúmulo de filas.

Resumindo, o LLD tem a capacidade de adicionar alguns novos recursos interessantes às redes DOCSIS tradicionais. Para entender exatamente como eles funcionam e ter um vislumbre dos ganhos de desempenho, montamos vários experimentos usando LLD em uma rede DOCSIS 3.1. Os resultados desses testes podem ser encontrados em nosso artigo técnico.

Também o convidamos a entrar em contato conosco para obter mais informações sobre o LLD e como ele pode funcionar em sua rede. A CommScope possui uma variedade de recursos disponíveis para ajudá-lo a capturar os benefícios desta especificação, melhorando a experiência do usuário e criando novas oportunidades de receita.

Nota aos leitores: o artigo original foi postado pela primeira vez em fevereiro de 2021 na publicação Modo rápido.